ИИ научился говорить как человек. И уже заменил гида, оператора и врача

NewsMakerМашины учатся говорить всё выразительнее.

Научные разработки в области искусственного интеллекта продолжают активно развиваться, и одним из самых впечатляющих достижений стала система J-Moshi , созданная в Японии. Модель стала первой в своём роде, предназначенной специально для передачи особенностей японской разговорной речи — включая такие важные элементы, как «айзути», короткие реплики вроде «Sou desu ne» (верно) и «Naruhodo» (понятно), которыми японцы показывают, что внимательно слушают собеседника. Именно способность вовремя вставлять подобные отклики делает беседу живой и естественной.

Обычные системы ИИ не справляются с такой задачей, так как не умеют одновременно слушать и говорить. J-Moshi удалось преодолеть это ограничение, что сделало систему особенно привлекательной для носителей языка. Пользователи отмечают, что разговаривать с ней — почти как с живым человеком.

Созданием J-Moshi занимались специалисты Университета Нагоя. Основой для проекта послужила англоязычная модель Moshi, разработанная в Kyutai, а на адаптацию к японскому языку ушло около четырёх месяцев. В процессе использовались обширные речевые датасеты, среди которых особо выделяется J-CHAT — крупнейшая открытая база японских диалогов, созданная Токийским университетом. Она содержит около 67 тысяч часов подкастов и роликов с YouTube. Кодовая база, используемая для обучения J-Moshi, доступна на GitHub .

Чтобы сделать систему более точной и многообразной, разработчики добавили в обучение устаревшие, но высококачественные диалоговые базы, а также данные, сгенерированные с помощью преобразования текстов чатов в речь. За счёт этого удалось компенсировать хронический дефицит японских речевых данных, который остаётся серьёзным препятствием для развития ИИ в стране.

Особую известность J-Moshi получила в январе 2024 года, когда демонстрационные видеоролики с ней стали вирусными в соцсетях. Помимо интереса со стороны лингвистов и энтузиастов, система вызвала ажиотаж среди изучающих японский язык — ведь теперь можно отрабатывать навыки общения с «естественным» собеседником.

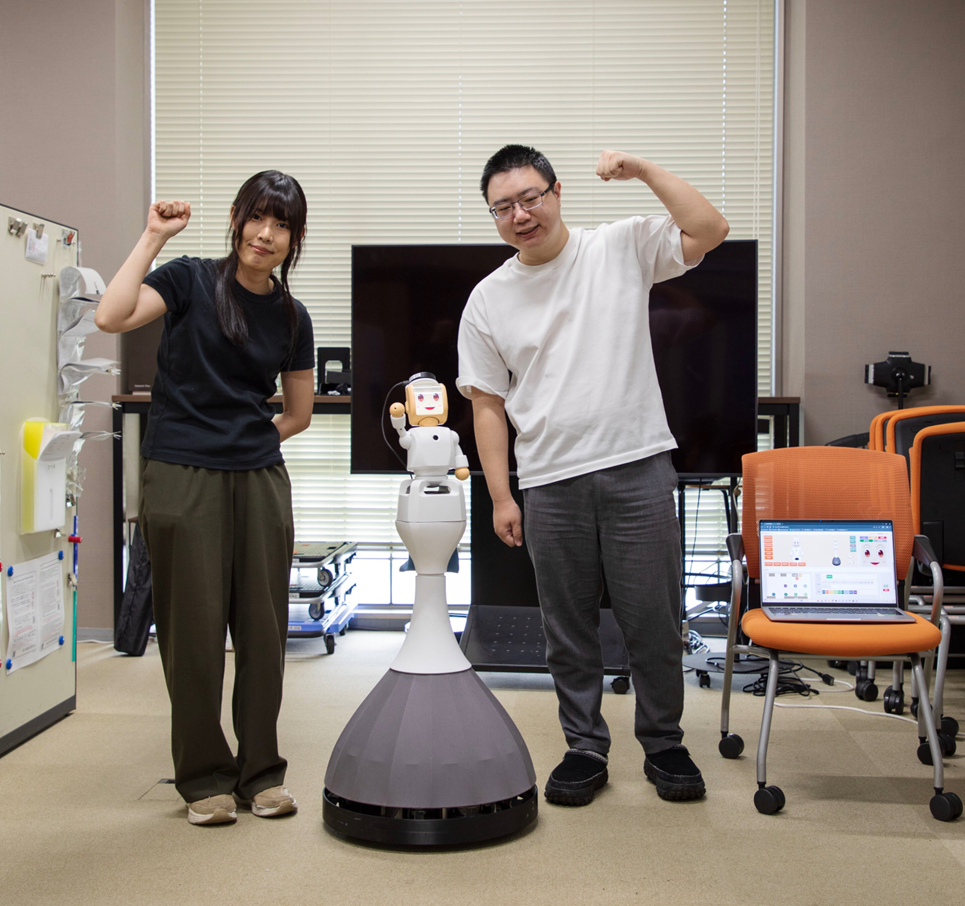

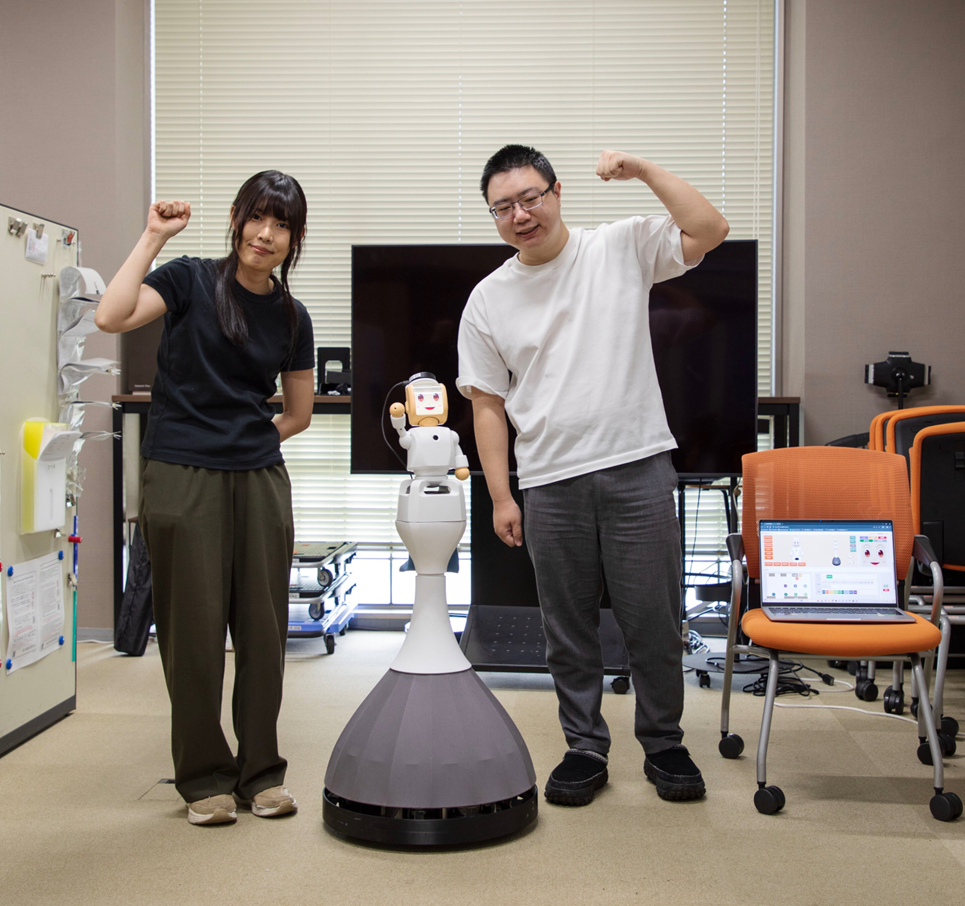

Кроме образовательной сферы, разрабатываются и коммерческие сценарии использования — от колл-центров до медицины и обслуживания клиентов. Система J-Moshi уже используется в говорящих роботах в публичных пространствах для ведения стандартных диалогов, а в случае сложных вопросов они могут оперативно соединять пользователя с живым оператором.

Говорящий робот с системой J-Moshi на борту (Мерл Наиду, Нагойский университет)

Однако встраивание J-Moshi в узкоспециализированные отрасли затруднено тем, что японская речь в этих сферах плохо документирована и почти не оцифрована. Помимо нехватки речевых данных, японским разработчикам мешают и проблемы приватности, из-за которых сложно собрать нужные аудиоматериалы. Некоторые решения включают программное разделение голосов в записях, где говорят сразу несколько человек.

Также остаются вызовы, связанные с восприятием социальной среды — например, ИИ плохо справляется, если человек носит маску или шляпу, скрывающие лицо. Чтобы повысить устойчивость таких систем, лаборатория работает над алгоритмами, способными распознавать, когда ИИ не справляется, и быстро передавать диалог человеку. Разрабатываются также гибридные методы взаимодействия, включающие не только речь, но и движения и жесты, что особенно актуально для гуманоидных роботов от Unitree Robotics, с которыми ведётся сотрудничество.

Исследование J-Moshi будет представлено на конференции Interspeech в Роттердаме в августе 2025 года. По словам авторов работы, в будущем нас ждут системы, которые смогут взаимодействовать с людьми неотличимо от реальных собеседников. Цель ученых — заложить технологическую основу для такого будущего.

Научные разработки в области искусственного интеллекта продолжают активно развиваться, и одним из самых впечатляющих достижений стала система J-Moshi , созданная в Японии. Модель стала первой в своём роде, предназначенной специально для передачи особенностей японской разговорной речи — включая такие важные элементы, как «айзути», короткие реплики вроде «Sou desu ne» (верно) и «Naruhodo» (понятно), которыми японцы показывают, что внимательно слушают собеседника. Именно способность вовремя вставлять подобные отклики делает беседу живой и естественной.

Обычные системы ИИ не справляются с такой задачей, так как не умеют одновременно слушать и говорить. J-Moshi удалось преодолеть это ограничение, что сделало систему особенно привлекательной для носителей языка. Пользователи отмечают, что разговаривать с ней — почти как с живым человеком.

Созданием J-Moshi занимались специалисты Университета Нагоя. Основой для проекта послужила англоязычная модель Moshi, разработанная в Kyutai, а на адаптацию к японскому языку ушло около четырёх месяцев. В процессе использовались обширные речевые датасеты, среди которых особо выделяется J-CHAT — крупнейшая открытая база японских диалогов, созданная Токийским университетом. Она содержит около 67 тысяч часов подкастов и роликов с YouTube. Кодовая база, используемая для обучения J-Moshi, доступна на GitHub .

Чтобы сделать систему более точной и многообразной, разработчики добавили в обучение устаревшие, но высококачественные диалоговые базы, а также данные, сгенерированные с помощью преобразования текстов чатов в речь. За счёт этого удалось компенсировать хронический дефицит японских речевых данных, который остаётся серьёзным препятствием для развития ИИ в стране.

Особую известность J-Moshi получила в январе 2024 года, когда демонстрационные видеоролики с ней стали вирусными в соцсетях. Помимо интереса со стороны лингвистов и энтузиастов, система вызвала ажиотаж среди изучающих японский язык — ведь теперь можно отрабатывать навыки общения с «естественным» собеседником.

Кроме образовательной сферы, разрабатываются и коммерческие сценарии использования — от колл-центров до медицины и обслуживания клиентов. Система J-Moshi уже используется в говорящих роботах в публичных пространствах для ведения стандартных диалогов, а в случае сложных вопросов они могут оперативно соединять пользователя с живым оператором.

Говорящий робот с системой J-Moshi на борту (Мерл Наиду, Нагойский университет)

Однако встраивание J-Moshi в узкоспециализированные отрасли затруднено тем, что японская речь в этих сферах плохо документирована и почти не оцифрована. Помимо нехватки речевых данных, японским разработчикам мешают и проблемы приватности, из-за которых сложно собрать нужные аудиоматериалы. Некоторые решения включают программное разделение голосов в записях, где говорят сразу несколько человек.

Также остаются вызовы, связанные с восприятием социальной среды — например, ИИ плохо справляется, если человек носит маску или шляпу, скрывающие лицо. Чтобы повысить устойчивость таких систем, лаборатория работает над алгоритмами, способными распознавать, когда ИИ не справляется, и быстро передавать диалог человеку. Разрабатываются также гибридные методы взаимодействия, включающие не только речь, но и движения и жесты, что особенно актуально для гуманоидных роботов от Unitree Robotics, с которыми ведётся сотрудничество.

Исследование J-Moshi будет представлено на конференции Interspeech в Роттердаме в августе 2025 года. По словам авторов работы, в будущем нас ждут системы, которые смогут взаимодействовать с людьми неотличимо от реальных собеседников. Цель ученых — заложить технологическую основу для такого будущего.