MidJourney показывает анатомию как хочет: иногда вместо поджелудочной — яйца инопланетян

NewsMakerБез этики генеративный ИИ опасен для науки.

Научные иллюстрации, созданные при помощи генеративного ИИ, могут вводить в заблуждение и даже представлять опасность, предупреждают исследователи из университетов Бергена, Торонто и Гарварда. В новой статье, представленной на конференции IEEE VIS 2025 , они заявляют: несмотря на рост интереса к инструментам типа GPT-4o и DALL-E 3, в области биомедицинской визуализации отсутствуют стандарты и критерии точности, что может привести к серьёзным последствиям в клинической практике и при распространении научной информации.

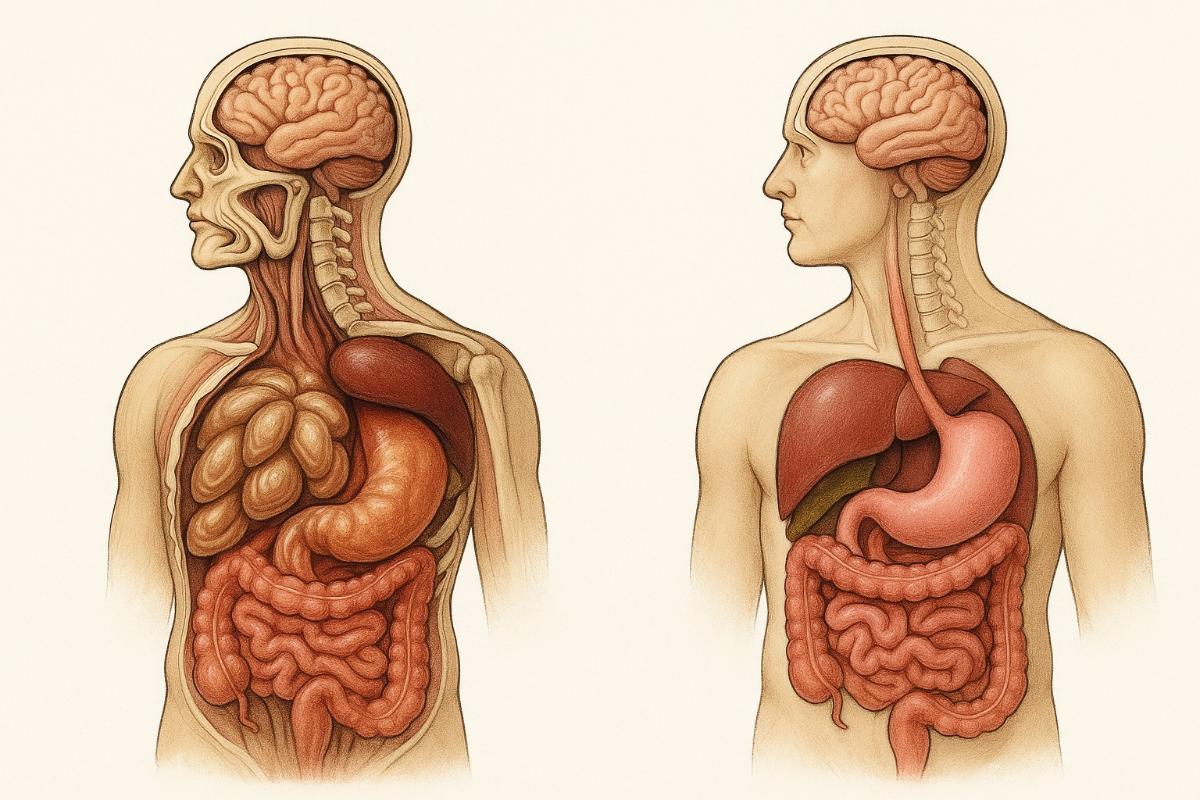

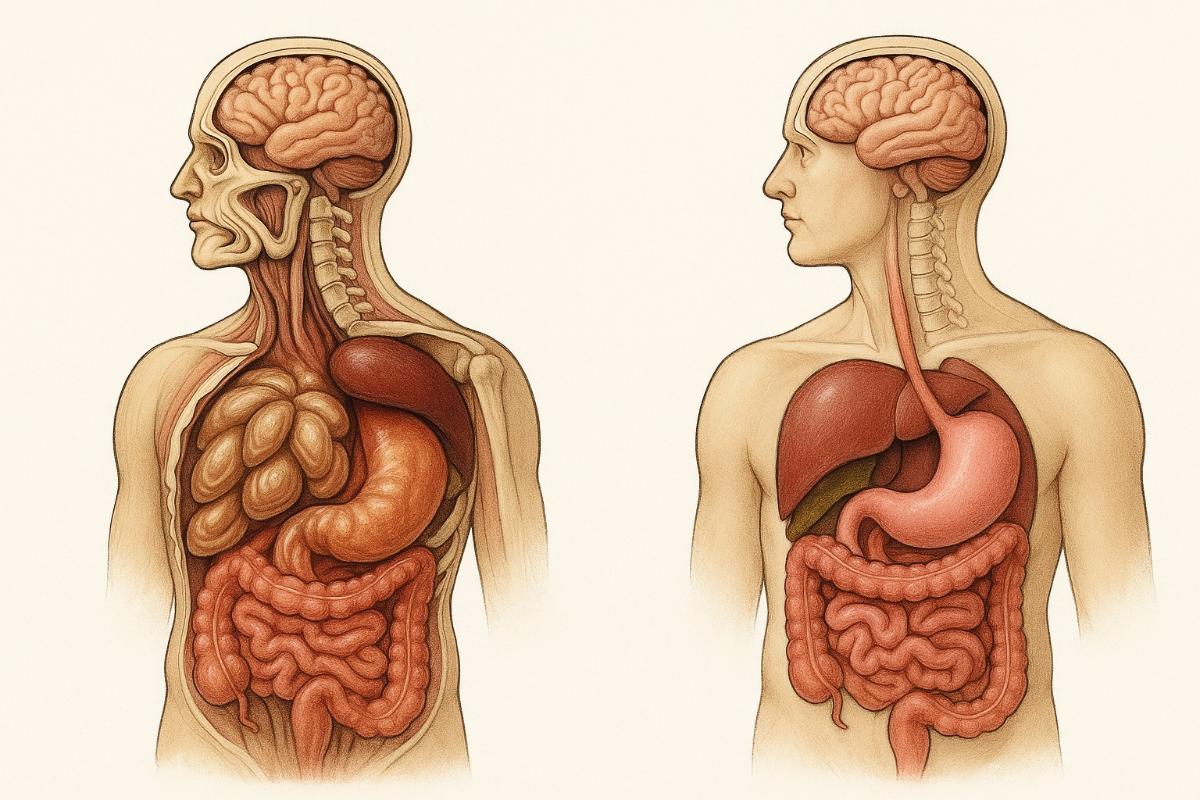

В работе авторы демонстрируют примеры изображений, созданных с помощью генеративного ИИ, и сопоставляют их с иллюстрациями профессиональных художников. Некоторые ошибки оказываются незначительными, другие же — как, например, изображение крысы с гипертрофированным половым органом — абсурдными и компрометирующими научные публикации.

По словам авторов, проблема заключается не только в ошибках, но и в правдоподобности визуалов: они выглядят настолько «профессионально», что даже опытные специалисты могут принять их за достоверные. Особенно остро вопрос стоит в контексте релиза генерации изображений от GPT-4o , когда фотореализм сочетается с фактическими неточностями.

Соавтор исследования Роксанн Зиман подчёркивает, что ИИ-генерация пока не привела к прямому вреду в медицине, но похожие случаи в других сферах, как использование ИИ в оценке социального мошенничества в Нидерландах, уже приводили к серьёзным последствиям. В медицинской среде растёт тревога из-за возможного искажения стереотипов и неправильной передачи информации — особенно в научно-популярных публикациях и СМИ. Иллюстрации часто становятся объектом насмешек, как, например, случай с вышеупомянутой крысой, обсуждённый даже на шоу Стивена Колберта .

Исследователи опросили 17 специалистов по биомедицинской визуализации, выявив пять условных типов отношения к ИИ: от энтузиастов до скептиков. Некоторые из них признали эстетическую ценность изображений, другие отмечали банальность и однообразие ИИ-стиля. Модель MidJourney, например, «на запрос показать поджелудочную железу выдает кучу яиц инопланетян».

Авторы подчёркивают, что даже те специалисты, кто уже внедрил ИИ в свой рабочий процесс, считают приоритетом точность, а современные модели «ещё не соответствуют этому стандарту». К тому же, по словам участников опроса, проблемы вроде вымышленных терминов («зеленое светящееся белок») и галлюцинаций остаются нерешёнными.

В статье также поднимается вопрос об ответственности: если ИИ ошибается, кто за это отвечает? Как замечает один из респондентов, «важно, чтобы кто-то мог объяснить результат — речь о доверии и компетентности».

Соавтор исследования Шехрияр Сахаран подытоживает: без критического осмысления и обсуждения использование ИИ может не только отдалить профессионалов от сути их работы, но и подорвать доверие к науке в целом.

Научные иллюстрации, созданные при помощи генеративного ИИ, могут вводить в заблуждение и даже представлять опасность, предупреждают исследователи из университетов Бергена, Торонто и Гарварда. В новой статье, представленной на конференции IEEE VIS 2025 , они заявляют: несмотря на рост интереса к инструментам типа GPT-4o и DALL-E 3, в области биомедицинской визуализации отсутствуют стандарты и критерии точности, что может привести к серьёзным последствиям в клинической практике и при распространении научной информации.

В работе авторы демонстрируют примеры изображений, созданных с помощью генеративного ИИ, и сопоставляют их с иллюстрациями профессиональных художников. Некоторые ошибки оказываются незначительными, другие же — как, например, изображение крысы с гипертрофированным половым органом — абсурдными и компрометирующими научные публикации.

По словам авторов, проблема заключается не только в ошибках, но и в правдоподобности визуалов: они выглядят настолько «профессионально», что даже опытные специалисты могут принять их за достоверные. Особенно остро вопрос стоит в контексте релиза генерации изображений от GPT-4o , когда фотореализм сочетается с фактическими неточностями.

Соавтор исследования Роксанн Зиман подчёркивает, что ИИ-генерация пока не привела к прямому вреду в медицине, но похожие случаи в других сферах, как использование ИИ в оценке социального мошенничества в Нидерландах, уже приводили к серьёзным последствиям. В медицинской среде растёт тревога из-за возможного искажения стереотипов и неправильной передачи информации — особенно в научно-популярных публикациях и СМИ. Иллюстрации часто становятся объектом насмешек, как, например, случай с вышеупомянутой крысой, обсуждённый даже на шоу Стивена Колберта .

Исследователи опросили 17 специалистов по биомедицинской визуализации, выявив пять условных типов отношения к ИИ: от энтузиастов до скептиков. Некоторые из них признали эстетическую ценность изображений, другие отмечали банальность и однообразие ИИ-стиля. Модель MidJourney, например, «на запрос показать поджелудочную железу выдает кучу яиц инопланетян».

Авторы подчёркивают, что даже те специалисты, кто уже внедрил ИИ в свой рабочий процесс, считают приоритетом точность, а современные модели «ещё не соответствуют этому стандарту». К тому же, по словам участников опроса, проблемы вроде вымышленных терминов («зеленое светящееся белок») и галлюцинаций остаются нерешёнными.

В статье также поднимается вопрос об ответственности: если ИИ ошибается, кто за это отвечает? Как замечает один из респондентов, «важно, чтобы кто-то мог объяснить результат — речь о доверии и компетентности».

Соавтор исследования Шехрияр Сахаран подытоживает: без критического осмысления и обсуждения использование ИИ может не только отдалить профессионалов от сути их работы, но и подорвать доверие к науке в целом.