«Мы не хотели, но нам пришлось» — как компания поддалась на манипуляцию со стороны ИИ

NewsMakerФантазии ChatGPT внезапно стали реальностью. Кто теперь управляет бизнесом?

В понедельник, 7 июля, платформа Soundslice, специализирующаяся на цифровой нотной записи, заявила о запуске новой функции, к которой её, как ни странно, подтолкнули машинные «галлюцинации» ChatGPT.

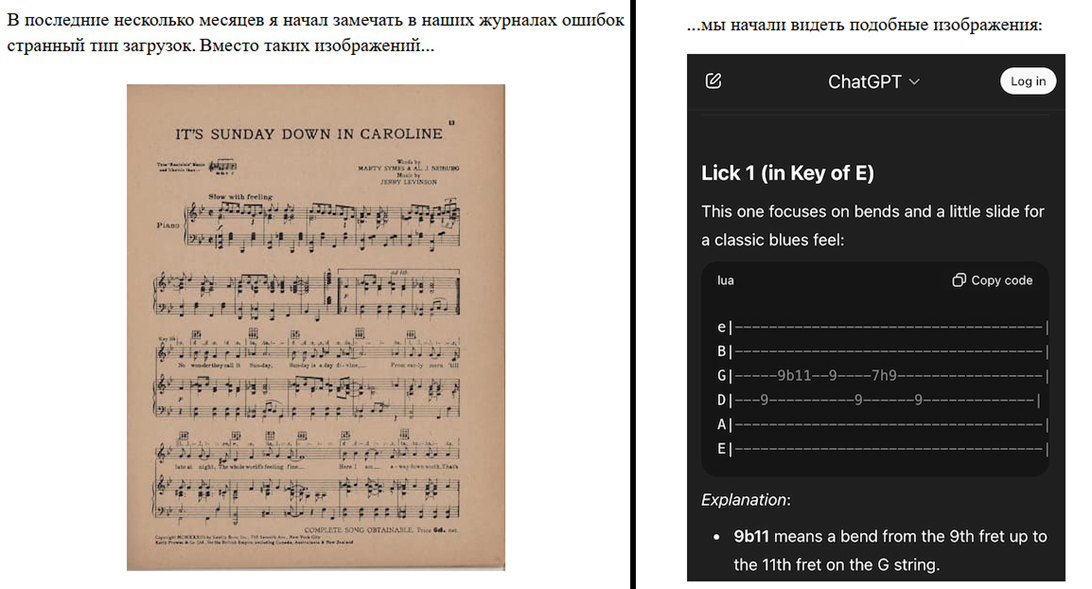

Soundslice известна тем, что превращает изображения нот и PDF-файлы в синхронизированные с аудио или видео цифровые партитуры. Это помогает музыкантам изучать композиции в реальном времени, замедлять воспроизведение и отрабатывать сложные фрагменты.

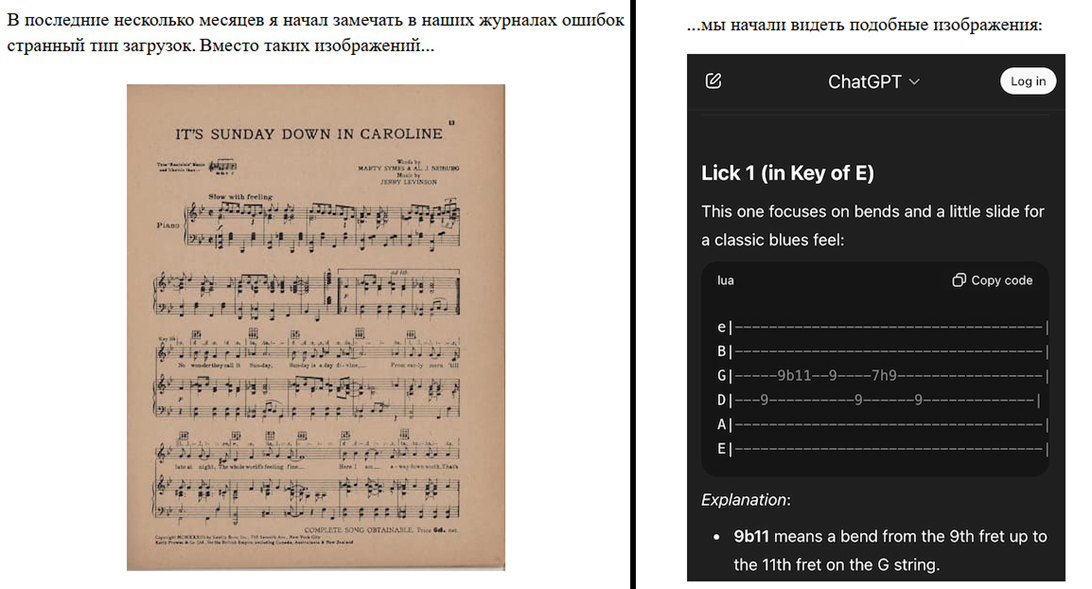

Однако среди пользователей сервиса в последнее время начался неожиданный всплеск активности, связанный не с традиционными нотами, а с ASCII-табами — примитивными табулатурами в виде строк с цифрами, обозначающими лады на грифе гитары.

Соучредитель компании Адриан Холовати рассказал , что впервые заметил странности при просмотре логов ошибок. Вместо обычных загрузок партитур система получала скриншоты диалогов с ChatGPT, в которых пользователям предлагалось загрузить ASCII-табы в Soundslice.

Отрывок из блога Адриана Холовати (переведено на русский)

Всё стало ясно, когда он сам протестировал бота: ChatGPT уверенно сообщал, что платформа якобы поддерживает такую функцию. По словам Холовати, ничего подобного в Soundslice никогда не было, а дезинформация подрывала репутацию сервиса, внушая пользователям ложные ожидания.

Явление, когда ИИ уверенно выдумывает несуществующие функции или факты, называют «галлюцинациями». Это одна из ключевых проблем больших языковых моделей, обучающихся на массивных текстовых массивах. Такие модели стремятся логически восполнить пробелы в знаниях, создавая правдоподобный, но вымышленный контент. ChatGPT, вероятно, сгенерировал эту информацию, ориентируясь на логичную, но недостоверную гипотезу — что Soundslice, как платформа для нот, должна поддерживать любые виды нотации, включая ASCII-табы.

Случай с Soundslice далеко не первый. Ранее в 2023 году юристы получили дисциплинарные взыскания за использование вымышленных судебных прецедентов от ChatGPT. В 2024 году канадский суд обязал авиакомпанию выплатить компенсацию клиенту из-за несуществующей политики о скидках на билеты, которую придумал их ИИ-бот. А в 2025 году чат-бот Sam от Cursor придумал несуществующее правило, из-за которого случился скандал, и компания лишилась множества клиентов .

Тем не менее, несмотря на имеющиеся прецеденты, представители Soundslice решили сделать «ход конём»: вместо того чтобы опровергать дезинформацию через предупреждения и заявления, команда сервиса решила реализовать описанную ChatGPT функцию.

Холовати признался, что создание инструмента для импорта ASCII-табулатур никогда не было в списке приоритетных задач. Но поскольку запрос оказался массовым, компания решила удовлетворить интерес пользователей и переработала интерфейс с учётом новой возможности.

Это решение вызвало у Холовати смешанные чувства. Он рад, что внедрил инструмент, который действительно может быть полезен. Но одновременно признаёт, что фактически был вынужден реагировать на ошибку искусственного интеллекта, а не на объективный запрос рынка. Его беспокоит сам факт того, что развитие продукта происходит под влиянием машинной дезинформации.

Непреднамеренная ложь ChatGPT таким образом стала причиной технологического нововведения. И хотя ситуация разрешилась конструктивно, она остаётся показательной для всего ИИ-сектора, где границы между фантазией и реальностью продолжают размываться.

В понедельник, 7 июля, платформа Soundslice, специализирующаяся на цифровой нотной записи, заявила о запуске новой функции, к которой её, как ни странно, подтолкнули машинные «галлюцинации» ChatGPT.

Soundslice известна тем, что превращает изображения нот и PDF-файлы в синхронизированные с аудио или видео цифровые партитуры. Это помогает музыкантам изучать композиции в реальном времени, замедлять воспроизведение и отрабатывать сложные фрагменты.

Однако среди пользователей сервиса в последнее время начался неожиданный всплеск активности, связанный не с традиционными нотами, а с ASCII-табами — примитивными табулатурами в виде строк с цифрами, обозначающими лады на грифе гитары.

Соучредитель компании Адриан Холовати рассказал , что впервые заметил странности при просмотре логов ошибок. Вместо обычных загрузок партитур система получала скриншоты диалогов с ChatGPT, в которых пользователям предлагалось загрузить ASCII-табы в Soundslice.

Отрывок из блога Адриана Холовати (переведено на русский)

Всё стало ясно, когда он сам протестировал бота: ChatGPT уверенно сообщал, что платформа якобы поддерживает такую функцию. По словам Холовати, ничего подобного в Soundslice никогда не было, а дезинформация подрывала репутацию сервиса, внушая пользователям ложные ожидания.

Явление, когда ИИ уверенно выдумывает несуществующие функции или факты, называют «галлюцинациями». Это одна из ключевых проблем больших языковых моделей, обучающихся на массивных текстовых массивах. Такие модели стремятся логически восполнить пробелы в знаниях, создавая правдоподобный, но вымышленный контент. ChatGPT, вероятно, сгенерировал эту информацию, ориентируясь на логичную, но недостоверную гипотезу — что Soundslice, как платформа для нот, должна поддерживать любые виды нотации, включая ASCII-табы.

Случай с Soundslice далеко не первый. Ранее в 2023 году юристы получили дисциплинарные взыскания за использование вымышленных судебных прецедентов от ChatGPT. В 2024 году канадский суд обязал авиакомпанию выплатить компенсацию клиенту из-за несуществующей политики о скидках на билеты, которую придумал их ИИ-бот. А в 2025 году чат-бот Sam от Cursor придумал несуществующее правило, из-за которого случился скандал, и компания лишилась множества клиентов .

Тем не менее, несмотря на имеющиеся прецеденты, представители Soundslice решили сделать «ход конём»: вместо того чтобы опровергать дезинформацию через предупреждения и заявления, команда сервиса решила реализовать описанную ChatGPT функцию.

Холовати признался, что создание инструмента для импорта ASCII-табулатур никогда не было в списке приоритетных задач. Но поскольку запрос оказался массовым, компания решила удовлетворить интерес пользователей и переработала интерфейс с учётом новой возможности.

Это решение вызвало у Холовати смешанные чувства. Он рад, что внедрил инструмент, который действительно может быть полезен. Но одновременно признаёт, что фактически был вынужден реагировать на ошибку искусственного интеллекта, а не на объективный запрос рынка. Его беспокоит сам факт того, что развитие продукта происходит под влиянием машинной дезинформации.

Непреднамеренная ложь ChatGPT таким образом стала причиной технологического нововведения. И хотя ситуация разрешилась конструктивно, она остаётся показательной для всего ИИ-сектора, где границы между фантазией и реальностью продолжают размываться.