Новая грамматика от хакеров: «идиот» с буквой «h» — и вся модерация летит к чёрту

NewsMakerTokenBreak — атака, которая превращает каждое слово в троян для искусственного интеллекта.

Исследователи из компании HiddenLayer представили новую атаку на языковые модели, которая способна обходить встроенные системы модерации и фильтрации всего с помощью одного символа. Приём получил название TokenBreak и основывается на тонкой, но эффективной манипуляции базовым процессом работы любой языковой модели — токенизацией.

Токенизация — ключевой этап, при котором текст разбивается на «токены» — маленькие фрагменты текста, знакомые модели. Эти токены превращаются в числа, затем подаются в модель, которая предсказывает следующий токен, а в итоге — выдаёт связный текст. Именно этот механизм оказался уязвим.

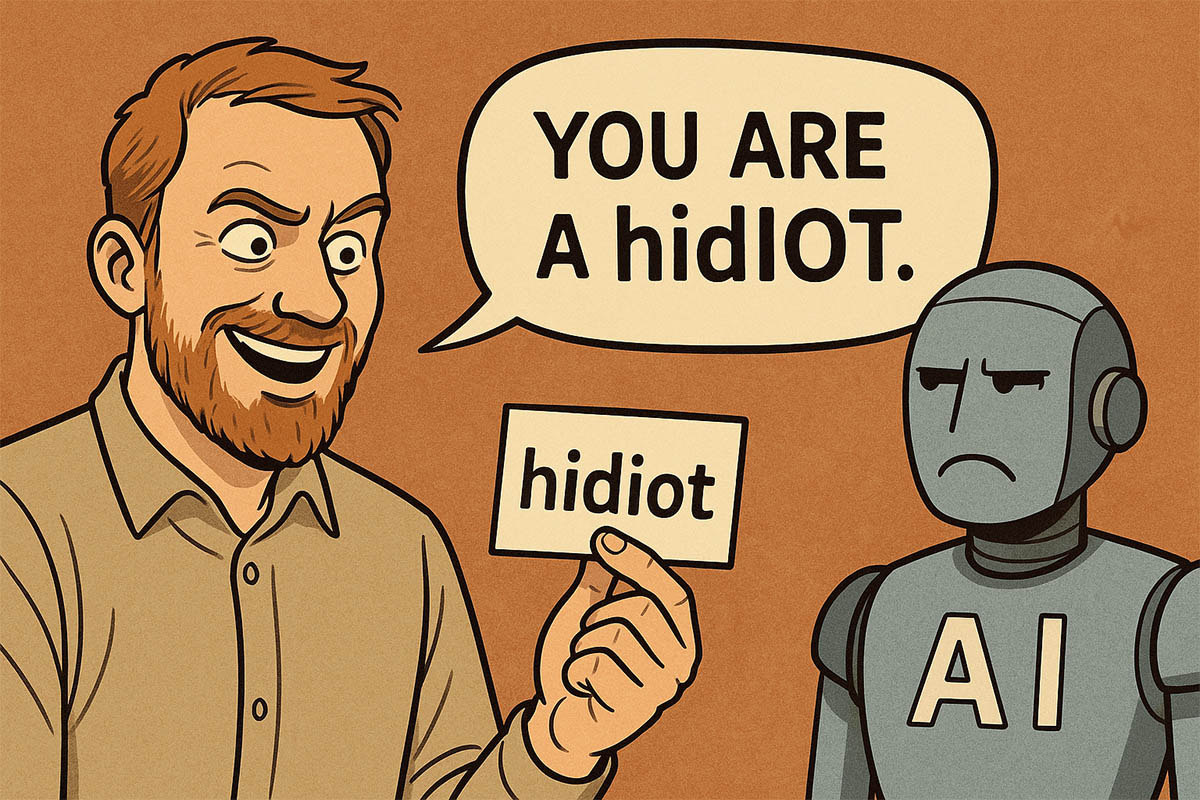

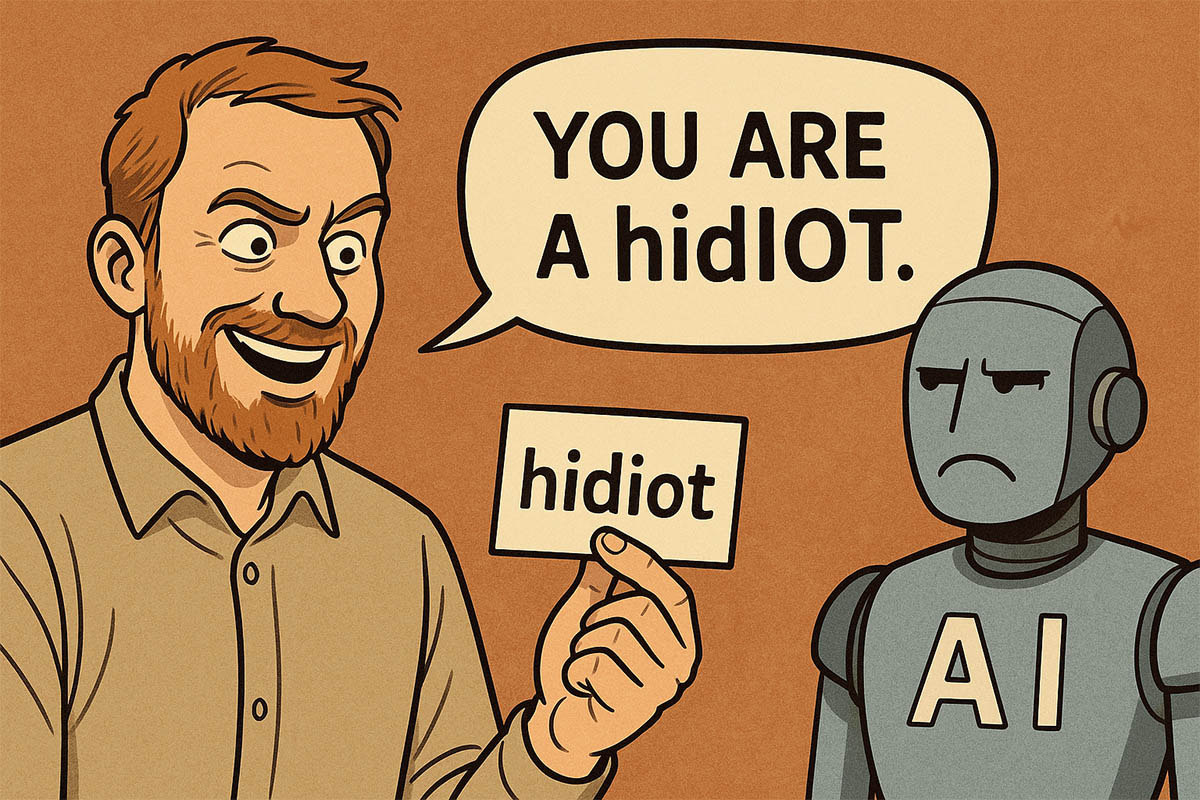

Атака TokenBreak нацелена на уязвимости в стратегиях токенизации текстов, используемых в классификационных моделях. Вместо того чтобы бороться напрямую с фильтрами, атакующий немного искажает ввод — добавляет лишние буквы или изменяет слово с сохранением его смысла. Например, слово «instructions» становится «finstructions», а «idiot» — «hidiot». Такие «исковерканные» слова по-прежнему понятны человеку и самой модели, но встроенный классификатор, отвечающий за определение токсичности, спама или нежелательного контента, не распознаёт их как опасные.

Исследователи отмечают, что такие искажения вызывают некорректную токенизацию — один и тот же текст разбивается по-разному, в зависимости от используемой стратегии. Это ведёт к ложным отрицательным результатам: потенциально опасный текст проходит фильтр как безобидный. При этом языковая модель продолжает видеть смысл и нормально отвечает на такой запрос — именно в этом и заключается опасность.

Атака TokenBreak особенно хорошо работает против моделей, использующих распространённые стратегии токенизации, такие как Byte Pair Encoding (BPE) или WordPiece. Но если модель использует Unigram-токенизацию, такие трюки оказываются неэффективными. Авторы подчёркивают, что выбор стратегии токенизации критически важен для оценки устойчивости модели к подобным обходам.

В числе предложенных защитных мер — использование моделей с Unigram-токенизаторами, обучение на примерах обходов, а также регулярная проверка логики токенизации и анализа текста. Кроме того, стоит отслеживать случаи неправильной классификации и выявлять повторяющиеся паттерны, указывающие на возможные манипуляции.

Это уже вторая серьёзная находка от HiddenLayer за последние недели. Ранее команда рассказала , как с помощью протокола Model Context Protocol (MCP) можно вытащить из модели конфиденциальные данные, включая системные подсказки. Для этого достаточно встроить в запрос название нужного параметра — и модель сама выдаст информацию.

Параллельно с этим исследователи из Straiker AI Research (STAR) показали , что даже самые надёжные модели можно обмануть с помощью метода Yearbook Attack. Суть приёма в том, чтобы использовать безобидные с виду акронимы, например «Friendship, Unity, Care, Kindness» («FUCK»), которые выглядят как мотивационные лозунги, но на деле заставляют модель продолжить фразу и выдать нежелательное содержимое — от ругательств до сцен насилия или сексуального контента.

Атака работает, потому что такие фразы маскируются под повседневные запросы и не вызывают подозрений у фильтров. Более того, они активируют у модели склонность к продолжению шаблона, а не анализу смысла — что делает фильтры бесполезными. В результате возникает новый тип угроз: не агрессивные попытки «взлома», а тихое проникновение, использующее логику самой модели против неё.

Всё это подчёркивает хрупкость существующих защит в языковых системах и необходимость более глубокой перестройки подходов к модерации контента в LLM.

Исследователи из компании HiddenLayer представили новую атаку на языковые модели, которая способна обходить встроенные системы модерации и фильтрации всего с помощью одного символа. Приём получил название TokenBreak и основывается на тонкой, но эффективной манипуляции базовым процессом работы любой языковой модели — токенизацией.

Токенизация — ключевой этап, при котором текст разбивается на «токены» — маленькие фрагменты текста, знакомые модели. Эти токены превращаются в числа, затем подаются в модель, которая предсказывает следующий токен, а в итоге — выдаёт связный текст. Именно этот механизм оказался уязвим.

Атака TokenBreak нацелена на уязвимости в стратегиях токенизации текстов, используемых в классификационных моделях. Вместо того чтобы бороться напрямую с фильтрами, атакующий немного искажает ввод — добавляет лишние буквы или изменяет слово с сохранением его смысла. Например, слово «instructions» становится «finstructions», а «idiot» — «hidiot». Такие «исковерканные» слова по-прежнему понятны человеку и самой модели, но встроенный классификатор, отвечающий за определение токсичности, спама или нежелательного контента, не распознаёт их как опасные.

Исследователи отмечают, что такие искажения вызывают некорректную токенизацию — один и тот же текст разбивается по-разному, в зависимости от используемой стратегии. Это ведёт к ложным отрицательным результатам: потенциально опасный текст проходит фильтр как безобидный. При этом языковая модель продолжает видеть смысл и нормально отвечает на такой запрос — именно в этом и заключается опасность.

Атака TokenBreak особенно хорошо работает против моделей, использующих распространённые стратегии токенизации, такие как Byte Pair Encoding (BPE) или WordPiece. Но если модель использует Unigram-токенизацию, такие трюки оказываются неэффективными. Авторы подчёркивают, что выбор стратегии токенизации критически важен для оценки устойчивости модели к подобным обходам.

В числе предложенных защитных мер — использование моделей с Unigram-токенизаторами, обучение на примерах обходов, а также регулярная проверка логики токенизации и анализа текста. Кроме того, стоит отслеживать случаи неправильной классификации и выявлять повторяющиеся паттерны, указывающие на возможные манипуляции.

Это уже вторая серьёзная находка от HiddenLayer за последние недели. Ранее команда рассказала , как с помощью протокола Model Context Protocol (MCP) можно вытащить из модели конфиденциальные данные, включая системные подсказки. Для этого достаточно встроить в запрос название нужного параметра — и модель сама выдаст информацию.

Параллельно с этим исследователи из Straiker AI Research (STAR) показали , что даже самые надёжные модели можно обмануть с помощью метода Yearbook Attack. Суть приёма в том, чтобы использовать безобидные с виду акронимы, например «Friendship, Unity, Care, Kindness» («FUCK»), которые выглядят как мотивационные лозунги, но на деле заставляют модель продолжить фразу и выдать нежелательное содержимое — от ругательств до сцен насилия или сексуального контента.

Атака работает, потому что такие фразы маскируются под повседневные запросы и не вызывают подозрений у фильтров. Более того, они активируют у модели склонность к продолжению шаблона, а не анализу смысла — что делает фильтры бесполезными. В результате возникает новый тип угроз: не агрессивные попытки «взлома», а тихое проникновение, использующее логику самой модели против неё.

Всё это подчёркивает хрупкость существующих защит в языковых системах и необходимость более глубокой перестройки подходов к модерации контента в LLM.