O3 уверена в себе, Claude — врач, DeepSeek — натуралист: кто кем стал в SciArena

NewsMakerОткрытый бой без масок: кто из LLM оказался ближе к настоящему учёному?

Allen Institute представил SciArena — открытую платформу для оценки качества ответов больших языковых моделей (LLM) в научных задачах. Проект ориентирован на сравнение моделей в условиях, приближенных к реальному использованию: с длинными вопросами, необходимостью ссылаться на научную литературу и соблюдением формального стиля.

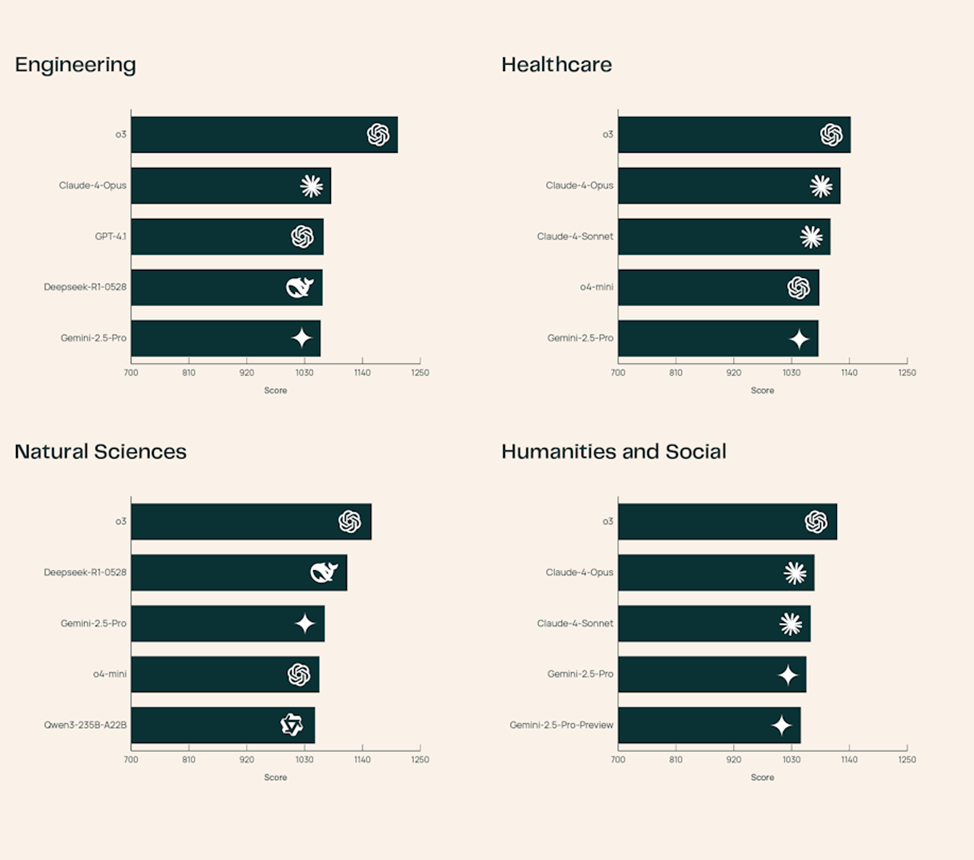

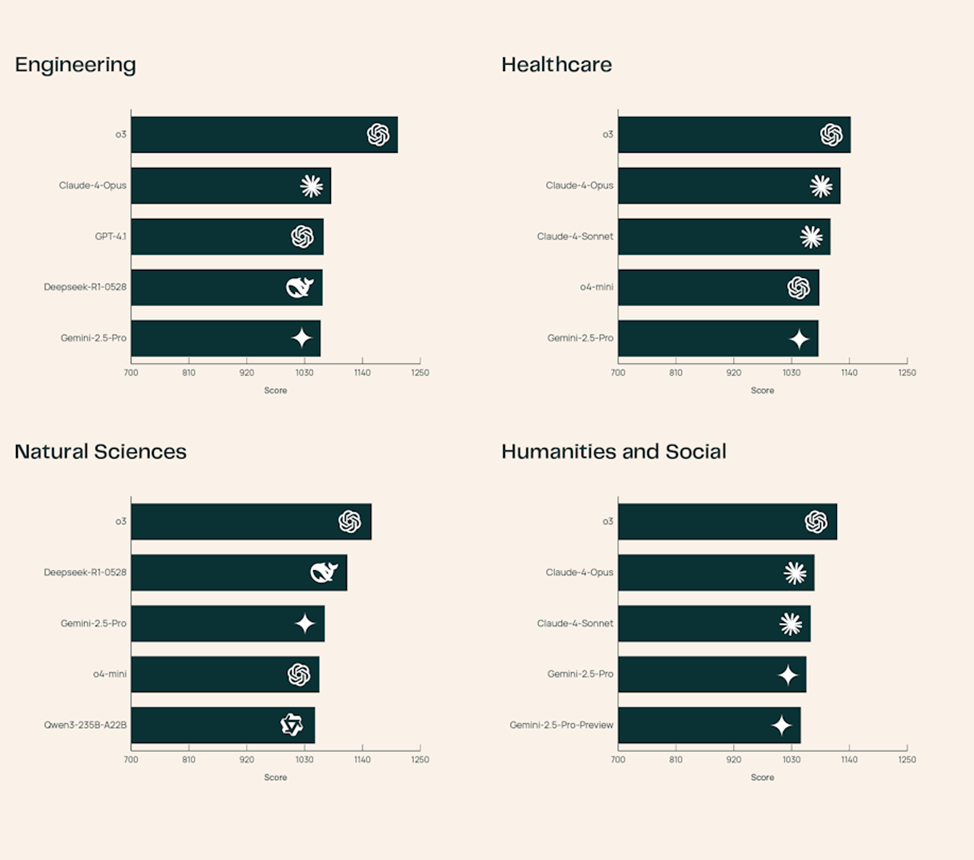

К 30 июня 2025 года на платформе протестировано 23 модели. Среди них лидирует o3 — она стабильно показывает лучшие результаты во всех дисциплинах и особенно уверенно работает в инженерной области. Claude-4-Opus лучше справляется с медицинскими задачами, а DeepSeek-R1-0528 выделяется в естественных науках.

Платформа построена по принципу парного голосования. Пользователь получает два ответа на научный вопрос, подготовленных разными моделями, и выбирает лучший. Авторы ответов не раскрываются до окончания голосования. Все модели работают в равных условиях, а тексты стандартизируются: одинаковый стиль цитирования, отсутствие форматирования, только plain-text.

SciArena использует адаптированный пайплайн Scholar QA от AI2 для поиска релевантных научных источников. Запросы разбиваются на подзадачи, происходит выборка и переоценка фрагментов статей, после чего они подаются в модели. В проекте участвуют только открытые модели — такие решения, как Perplexity или Deep Research от OpenAI, не рассматриваются из-за сложности сравнения.

За первые четыре месяца работы на платформе было собрано более 13 000 голосов от 102 учёных с опытом публикаций и навыками работы с ИИ-инструментами. Все участники прошли обучающую сессию. Проверка качества аннотаций показала высокую степень согласия между экспертами (κ=0,76) и стабильность их решений во времени (κ=0,91).

Оценка качества самих моделей также выявила проблемы. Даже o3 — лидер платформы — предсказала предпочтения пользователей лишь в 65,1% случаев. Для сравнения, на неспециализированных задачах AlpacaEval и WildChat этот показатель выше 70%. Это указывает на сложность оценки научных ответов и необходимость более точных автоматических метрик.

Команда SciArena планирует расширять список моделей. В перспективе рассматриваются эксперименты с другими элементами пайплайна — от способов индексации до вариантов построения подсказок. Сейчас они заданы жёстко для обеспечения чистоты сравнения, но в будущем могут стать частью оценки.

Платформа уже доступна для участия: любой исследователь может голосовать, отслеживать изменения в рейтинге и использовать открытые данные и код для собственных проектов. Также опубликована научная статья , в которой подробно описаны методология и результаты проекта.

Allen Institute представил SciArena — открытую платформу для оценки качества ответов больших языковых моделей (LLM) в научных задачах. Проект ориентирован на сравнение моделей в условиях, приближенных к реальному использованию: с длинными вопросами, необходимостью ссылаться на научную литературу и соблюдением формального стиля.

К 30 июня 2025 года на платформе протестировано 23 модели. Среди них лидирует o3 — она стабильно показывает лучшие результаты во всех дисциплинах и особенно уверенно работает в инженерной области. Claude-4-Opus лучше справляется с медицинскими задачами, а DeepSeek-R1-0528 выделяется в естественных науках.

Платформа построена по принципу парного голосования. Пользователь получает два ответа на научный вопрос, подготовленных разными моделями, и выбирает лучший. Авторы ответов не раскрываются до окончания голосования. Все модели работают в равных условиях, а тексты стандартизируются: одинаковый стиль цитирования, отсутствие форматирования, только plain-text.

SciArena использует адаптированный пайплайн Scholar QA от AI2 для поиска релевантных научных источников. Запросы разбиваются на подзадачи, происходит выборка и переоценка фрагментов статей, после чего они подаются в модели. В проекте участвуют только открытые модели — такие решения, как Perplexity или Deep Research от OpenAI, не рассматриваются из-за сложности сравнения.

За первые четыре месяца работы на платформе было собрано более 13 000 голосов от 102 учёных с опытом публикаций и навыками работы с ИИ-инструментами. Все участники прошли обучающую сессию. Проверка качества аннотаций показала высокую степень согласия между экспертами (κ=0,76) и стабильность их решений во времени (κ=0,91).

Оценка качества самих моделей также выявила проблемы. Даже o3 — лидер платформы — предсказала предпочтения пользователей лишь в 65,1% случаев. Для сравнения, на неспециализированных задачах AlpacaEval и WildChat этот показатель выше 70%. Это указывает на сложность оценки научных ответов и необходимость более точных автоматических метрик.

Команда SciArena планирует расширять список моделей. В перспективе рассматриваются эксперименты с другими элементами пайплайна — от способов индексации до вариантов построения подсказок. Сейчас они заданы жёстко для обеспечения чистоты сравнения, но в будущем могут стать частью оценки.

Платформа уже доступна для участия: любой исследователь может голосовать, отслеживать изменения в рейтинге и использовать открытые данные и код для собственных проектов. Также опубликована научная статья , в которой подробно описаны методология и результаты проекта.