Умный, значит способный? Мечты об AGI снова отодвигаются на неопределённый срок

NewsMakerРазница между симуляцией и реальным мышлением оказалась болезненно очевидной.

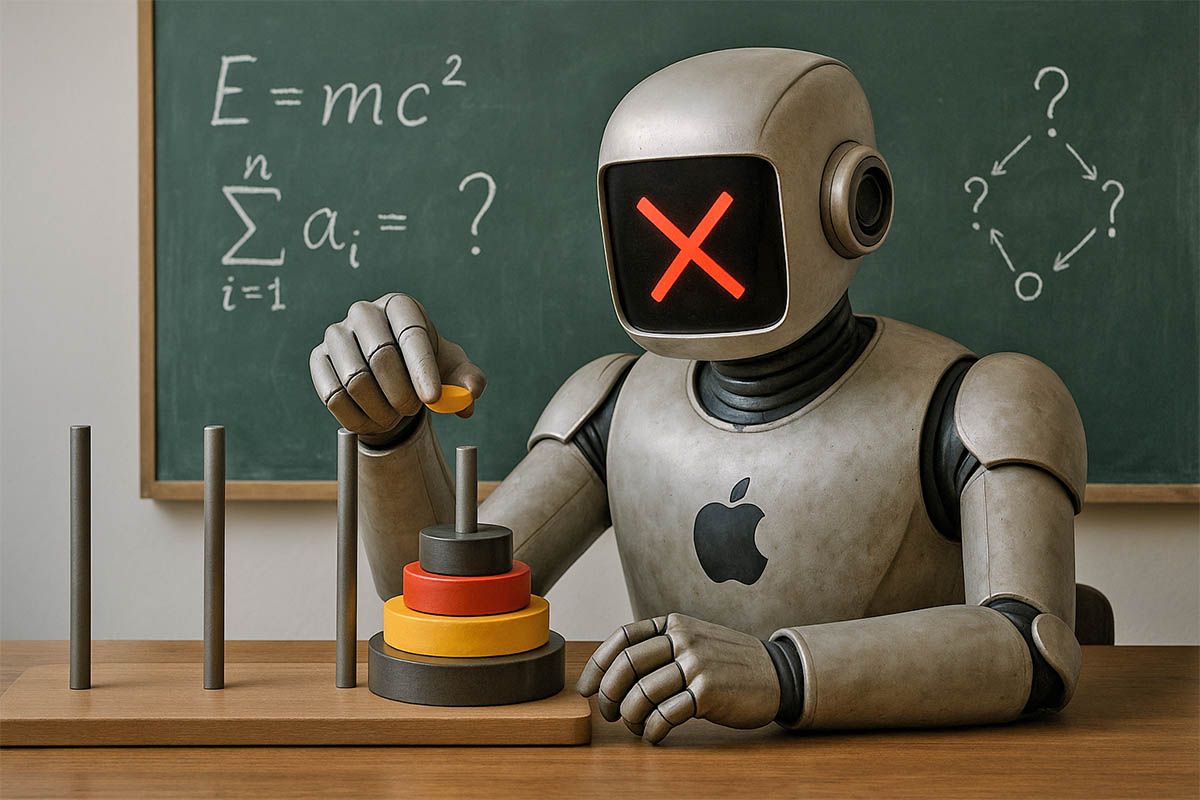

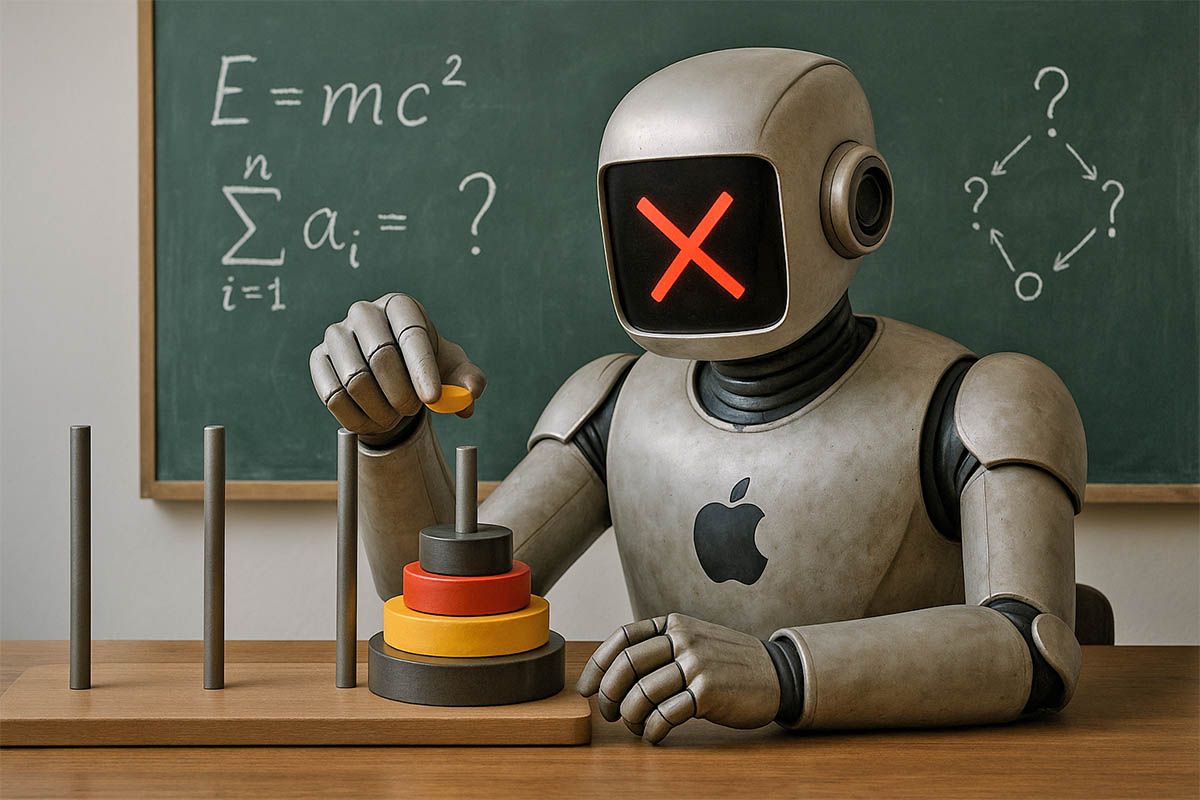

Если кто-то всерьёз рассчитывает на появление сильного искусственного интеллекта ( AGI ) уже в следующем году, возможно, стоит умерить свои ожидания . Новое исследование , проведённое сотрудниками Apple, показывает, что способность продвинутых языковых моделей к «мышлению» стремительно рушится, как только задачи становятся по-настоящему сложными. Несмотря на название «Large Reasoning Models» (LRM) — крупные рассуждающие модели — они оказались плохо приспособлены к планированию и обобщению даже в контролируемых условиях.

Работа под названием «Иллюзия мышления: понимание сильных и слабых сторон моделей рассуждения через призму сложности задач» ставит под сомнение потенциал современных подходов к созданию ИИ, способного по-настоящему мыслить. Вместо классических бенчмарков , нередко дискредитированных из-за утечки тестовых данных в обучающие датасеты или откровенного «читерства» со стороны разработчиков, команда предложила моделям уникальное среду — набор головоломок с контролируемым уровнем сложности.

К примеру, в задаче «Башня Ханоя» ИИ должен пошагово переставить диски с одного штыря на другой, соблюдая определённые правила — типичная задача на планирование и стратегию.

Тестирование охватывало модели от ведущих лабораторий: OpenAI (o1/o3), DeepSeek-R1, Claude 3.7 Sonnet Thinking и Gemini Thinking. Все они демонстрировали некий уровень успеха на простых и умеренно сложных задачах, но по мере роста числа необходимых шагов их способности буквально рушились. За сложным рубежом эффективность моделей обрушивалась почти до нуля. Это касалось и продвинутых LRM с встроенными механизмами саморефлексии, натренированными с помощью обучения с подкреплением.

При этом парадокс заключался в том, что LRM справлялись хуже, чем обычные большие языковые модели на простых задачах. Вместо того чтобы остановиться на найденном решении, они продолжали искать дальше, расходуя ресурсы на ненужные вычисления.

Главный вывод исследователей — крупные рассуждающие модели пока не открывают путь к настоящему машинному мышлению. Механизмы, вроде цепочек размышлений (Chain of Thought), не дают ожидаемого эффекта за пределами простых сценариев. По сути, всё сводится к перебору, и в условиях ограничений по вычислениям или времени это может оказаться тупиковой стратегией.

Авторы подчёркивают, что несмотря на видимую продвинутость, современные рассуждающие модели не приобретают навыков универсального решения задач. Это ставит под сомнение популярные предположения о том, что добавление этапов размышлений — верный путь к AGI.

Публикация добавляет сомнений в представления о ближайшем будущем ИИ. Даже если модели способны симулировать логические цепочки, это ещё не значит, что они действительно «думают». Вопрос о способности машин к обобщённому разуму остаётся открытым — и, судя по всему, путь к нему будет намного длиннее, чем казалось ещё год назад.

Если кто-то всерьёз рассчитывает на появление сильного искусственного интеллекта ( AGI ) уже в следующем году, возможно, стоит умерить свои ожидания . Новое исследование , проведённое сотрудниками Apple, показывает, что способность продвинутых языковых моделей к «мышлению» стремительно рушится, как только задачи становятся по-настоящему сложными. Несмотря на название «Large Reasoning Models» (LRM) — крупные рассуждающие модели — они оказались плохо приспособлены к планированию и обобщению даже в контролируемых условиях.

Работа под названием «Иллюзия мышления: понимание сильных и слабых сторон моделей рассуждения через призму сложности задач» ставит под сомнение потенциал современных подходов к созданию ИИ, способного по-настоящему мыслить. Вместо классических бенчмарков , нередко дискредитированных из-за утечки тестовых данных в обучающие датасеты или откровенного «читерства» со стороны разработчиков, команда предложила моделям уникальное среду — набор головоломок с контролируемым уровнем сложности.

К примеру, в задаче «Башня Ханоя» ИИ должен пошагово переставить диски с одного штыря на другой, соблюдая определённые правила — типичная задача на планирование и стратегию.

Тестирование охватывало модели от ведущих лабораторий: OpenAI (o1/o3), DeepSeek-R1, Claude 3.7 Sonnet Thinking и Gemini Thinking. Все они демонстрировали некий уровень успеха на простых и умеренно сложных задачах, но по мере роста числа необходимых шагов их способности буквально рушились. За сложным рубежом эффективность моделей обрушивалась почти до нуля. Это касалось и продвинутых LRM с встроенными механизмами саморефлексии, натренированными с помощью обучения с подкреплением.

При этом парадокс заключался в том, что LRM справлялись хуже, чем обычные большие языковые модели на простых задачах. Вместо того чтобы остановиться на найденном решении, они продолжали искать дальше, расходуя ресурсы на ненужные вычисления.

Главный вывод исследователей — крупные рассуждающие модели пока не открывают путь к настоящему машинному мышлению. Механизмы, вроде цепочек размышлений (Chain of Thought), не дают ожидаемого эффекта за пределами простых сценариев. По сути, всё сводится к перебору, и в условиях ограничений по вычислениям или времени это может оказаться тупиковой стратегией.

Авторы подчёркивают, что несмотря на видимую продвинутость, современные рассуждающие модели не приобретают навыков универсального решения задач. Это ставит под сомнение популярные предположения о том, что добавление этапов размышлений — верный путь к AGI.

Публикация добавляет сомнений в представления о ближайшем будущем ИИ. Даже если модели способны симулировать логические цепочки, это ещё не значит, что они действительно «думают». Вопрос о способности машин к обобщённому разуму остаётся открытым — и, судя по всему, путь к нему будет намного длиннее, чем казалось ещё год назад.