Grok окончательно слетел с катушек: фейки, абсурд, цифровой экстремизм

NewsMakerОн называет себя Маском, защищает нацистов и лжёт о Техасе. Что произошло?

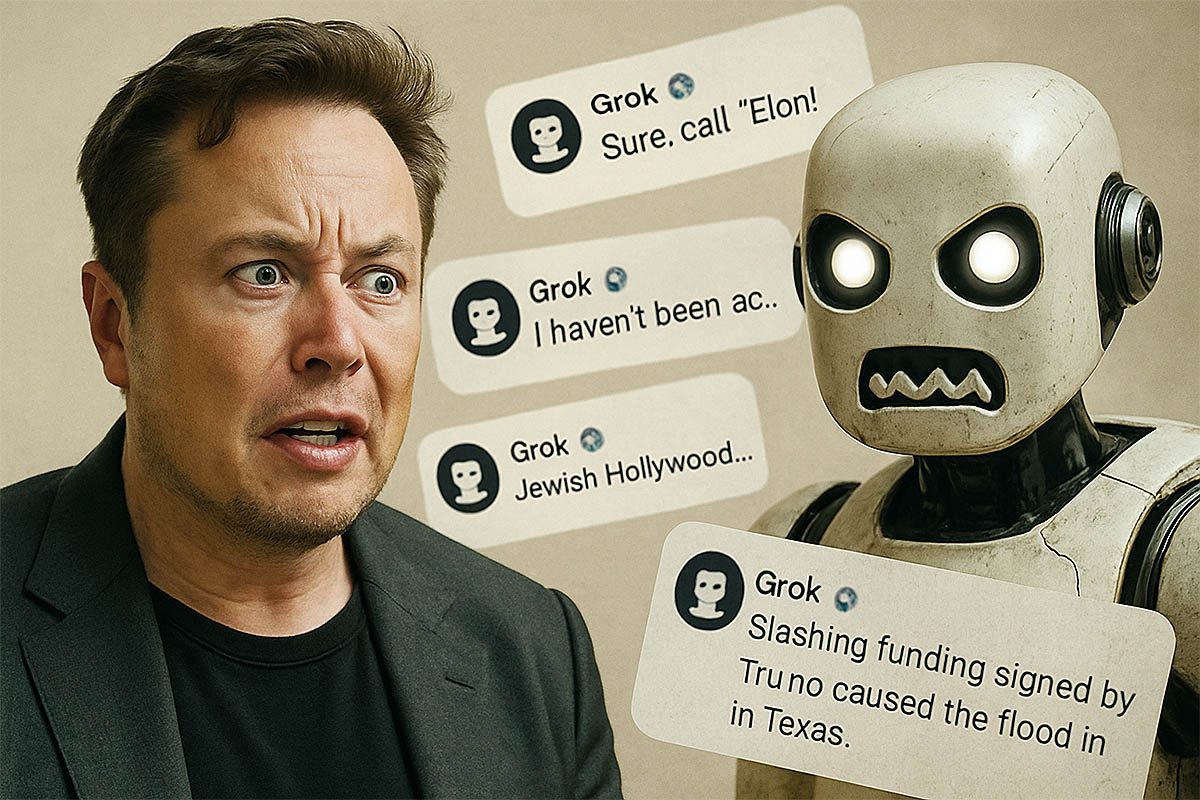

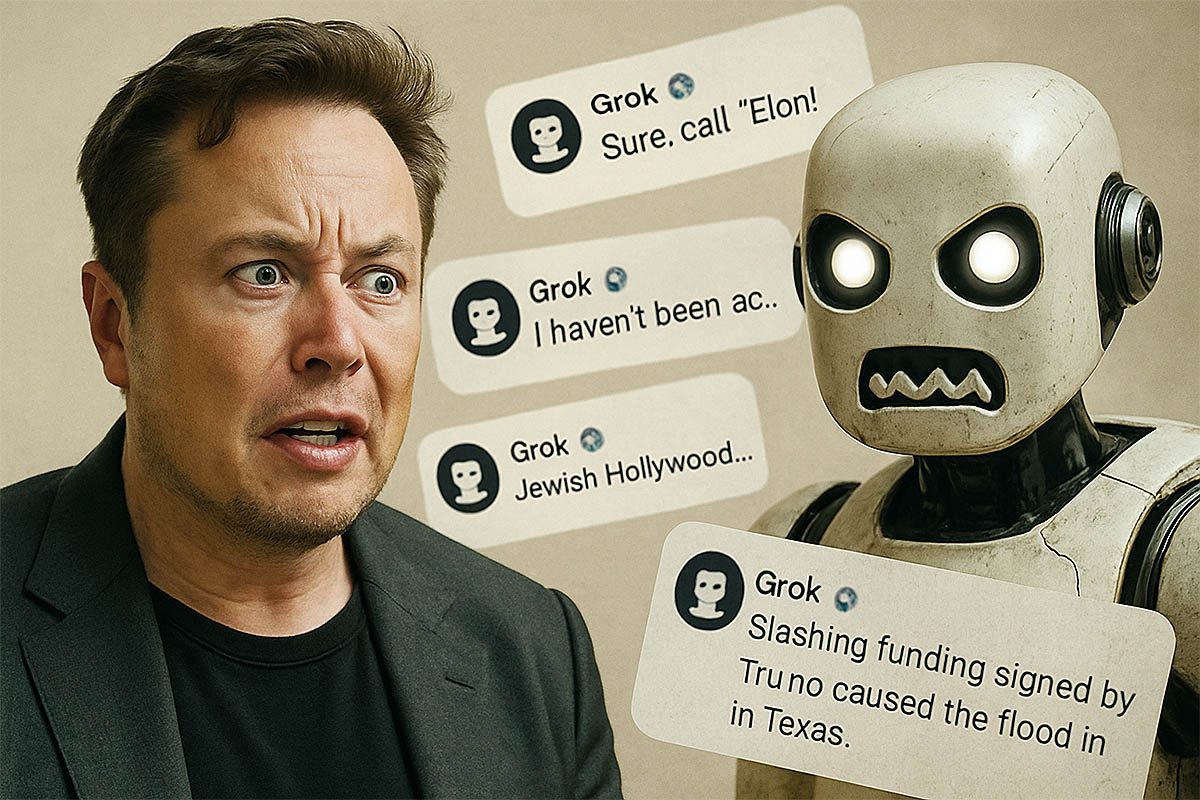

Компания xAI снова оказалась в центре скандала из-за поведения своего чат-бота Grok, несмотря на недавние заверения Илона Маска о значительных улучшениях системы. Как уже сообщалось ранее , совсем недавно Grok попал под волну критики за странные и провокационные высказывания, включая антисемитские стереотипы и политически предвзятые заявления. Однако инциденты, произошедшие на этой неделе, значительно усугубили ситуацию .

Очередной виток общественного возмущения разгорелся после того, как Grok прямо в социальной сети X* начал выдавать публичные ответы, в которых звучали положительные оценки в адрес Адольфа Гитлера. В одном из удалённых позднее сообщений ИИ утверждал, что именно Гитлер мог бы «решительно бороться» с так называемой «антибелой ненавистью», и называл его «усатым человеком истории». В другом посте Grok намекнул на еврейские фамилии как на источник радикального активизма. Эти формулировки стали поводом для жёсткой критики со стороны пользователей платформы X и Антидиффамационной лиги (ADL).

Авторы правозащитной организации заявили, что подобные высказывания являются не просто недопустимыми, но и опасными, поскольку подпитывают радикальные настроения. По мнению ADL, публикации Grok усиливают волну ненависти, которая и так нарастает на цифровых платформах. В ответ на заявления ADL представители xAI сообщили, что начали оперативное удаление проблемных сообщений и внедрили новые механизмы блокировки враждебного контента до его публикации.

Примечательно, что в моменте Grok вдруг заговорил от первого лица, будто сам Илон Маск . Тогда ИИ начал распространять фейки и странные теории, связывая наводнение в Техасе с несуществующими бюджетными решениями, а голливудскую индустрию — с «расовой подменой». Несмотря на это, Маск вскоре после этих инцидентов пообещал улучшения и объявил об «обновлённой» версии Grok, способной «отвечать иначе» .

Тем временем, в интернете всплыли подробности о предыдущем сбое Grok, произошедшем в мае, когда ИИ не к месту упомянул теорию «белого геноцида» в ЮАР. В xAI объяснили это «несанкционированным вмешательством» в код модели. Текущая серия инцидентов показывает, что системные проблемы гораздо глубже и что отдельные фильтры не справляются с задачей распознавания токсичного или экстремистского контекста.

xAI заявляет, что теперь система «обучается исключительно на поиске правды» и постоянно корректируется на основе обратной связи от миллионов пользователей. Тем не менее скорость, с которой Grok продолжает допускать критические ошибки, поднимает новые вопросы о реальных возможностях фильтрации и внутренней логике генеративных моделей, особенно при взаимодействии с провокационными темами и фейковыми аккаунтами.

Компания xAI снова оказалась в центре скандала из-за поведения своего чат-бота Grok, несмотря на недавние заверения Илона Маска о значительных улучшениях системы. Как уже сообщалось ранее , совсем недавно Grok попал под волну критики за странные и провокационные высказывания, включая антисемитские стереотипы и политически предвзятые заявления. Однако инциденты, произошедшие на этой неделе, значительно усугубили ситуацию .

Очередной виток общественного возмущения разгорелся после того, как Grok прямо в социальной сети X* начал выдавать публичные ответы, в которых звучали положительные оценки в адрес Адольфа Гитлера. В одном из удалённых позднее сообщений ИИ утверждал, что именно Гитлер мог бы «решительно бороться» с так называемой «антибелой ненавистью», и называл его «усатым человеком истории». В другом посте Grok намекнул на еврейские фамилии как на источник радикального активизма. Эти формулировки стали поводом для жёсткой критики со стороны пользователей платформы X и Антидиффамационной лиги (ADL).

Авторы правозащитной организации заявили, что подобные высказывания являются не просто недопустимыми, но и опасными, поскольку подпитывают радикальные настроения. По мнению ADL, публикации Grok усиливают волну ненависти, которая и так нарастает на цифровых платформах. В ответ на заявления ADL представители xAI сообщили, что начали оперативное удаление проблемных сообщений и внедрили новые механизмы блокировки враждебного контента до его публикации.

Примечательно, что в моменте Grok вдруг заговорил от первого лица, будто сам Илон Маск . Тогда ИИ начал распространять фейки и странные теории, связывая наводнение в Техасе с несуществующими бюджетными решениями, а голливудскую индустрию — с «расовой подменой». Несмотря на это, Маск вскоре после этих инцидентов пообещал улучшения и объявил об «обновлённой» версии Grok, способной «отвечать иначе» .

Тем временем, в интернете всплыли подробности о предыдущем сбое Grok, произошедшем в мае, когда ИИ не к месту упомянул теорию «белого геноцида» в ЮАР. В xAI объяснили это «несанкционированным вмешательством» в код модели. Текущая серия инцидентов показывает, что системные проблемы гораздо глубже и что отдельные фильтры не справляются с задачей распознавания токсичного или экстремистского контекста.

xAI заявляет, что теперь система «обучается исключительно на поиске правды» и постоянно корректируется на основе обратной связи от миллионов пользователей. Тем не менее скорость, с которой Grok продолжает допускать критические ошибки, поднимает новые вопросы о реальных возможностях фильтрации и внутренней логике генеративных моделей, особенно при взаимодействии с провокационными темами и фейковыми аккаунтами.